商傳媒|記者責任編輯/綜合外電報導

全球AI晶片龍頭輝達(Nvidia)於美國消費電子展(CES)發表新一代AI晶片平台「Vera Rubin」,執行長黃仁勳宣布已進入全面量產階段,強調相較前代晶片,AI推理運算效能提升可達五倍;根據《路透》報導,該平台可整合高達1,000顆晶片進行超大規模AI模型部署,將重塑生成式AI與資料中心格局。

黃仁勳在今年拉斯維加斯的CES主題演講中宣布,代號「Vera Rubin」的新一代AI平台將於2026年內全面商用,現階段已進入實驗室測試階段,並與核心AI客戶合作中。此平台結合六顆Rubin晶片構成單一模組,旗艦伺服器則整合72顆GPU與36顆CPU,可串聯成由逾千顆晶片構成的AI運算艙(pods),效能提升十倍,專為生成式AI與大型語言模型(LLM)優化。

黃仁勳強調:「即便僅增加1.6倍的電晶體數量,我們依舊實現了顯著效能飛躍,關鍵在於資料架構的根本革新。」

專屬格式結合Context Memory 強化AI對話回應效率

Rubin晶片的效能提升背後,依賴一種輝達自創的專屬資料格式,期望業界廣泛採用,形成新標準。平台同時引入名為「Context Memory Storage」的儲存層級,專為加速聊天機器人回應速度設計,有助於長對話時提升語境記憶與回應連貫性。

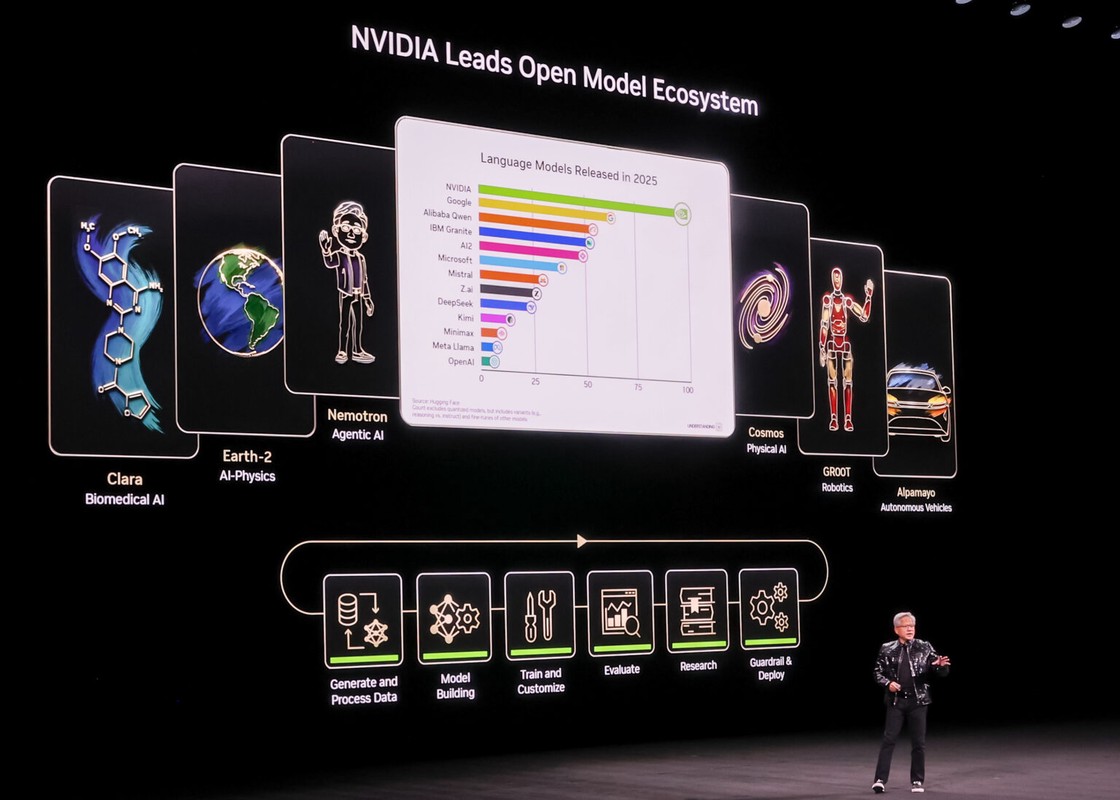

儘管輝達在AI訓練市場仍具壓倒性優勢,但在推理應用(Inference)方面,正面臨Google、AMD與Meta等既是客戶也是潛在競爭者的挑戰。黃仁勳這次特別強調Rubin平台能有效擴展至終端應用,從大型語言模型推理,到自駕車決策系統與資料中心布建,全面涵蓋AI落地場景。

核心夥伴提前導入 Microsoft、Amazon入列採用

輝達宣稱,雲端運算新創CoreWeave將率先採用Vera Rubin平台,微軟(Microsoft)、亞馬遜(Amazon)、甲骨文(Oracle)與Google等科技巨擘亦名列潛在採購方名單。報導分析指出,這象徵輝達正嘗試透過新平台強化生態鏈鎖定,防範大型雲端業者自研晶片分食市場。

開放自駕車AI模型與訓練數據 強調可信性

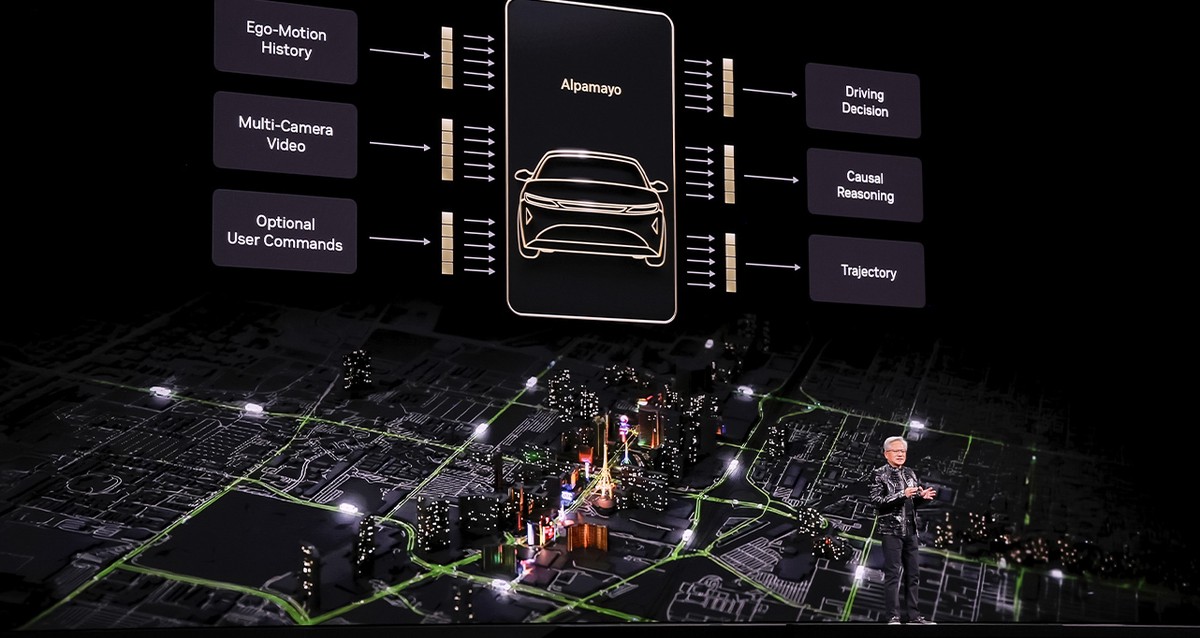

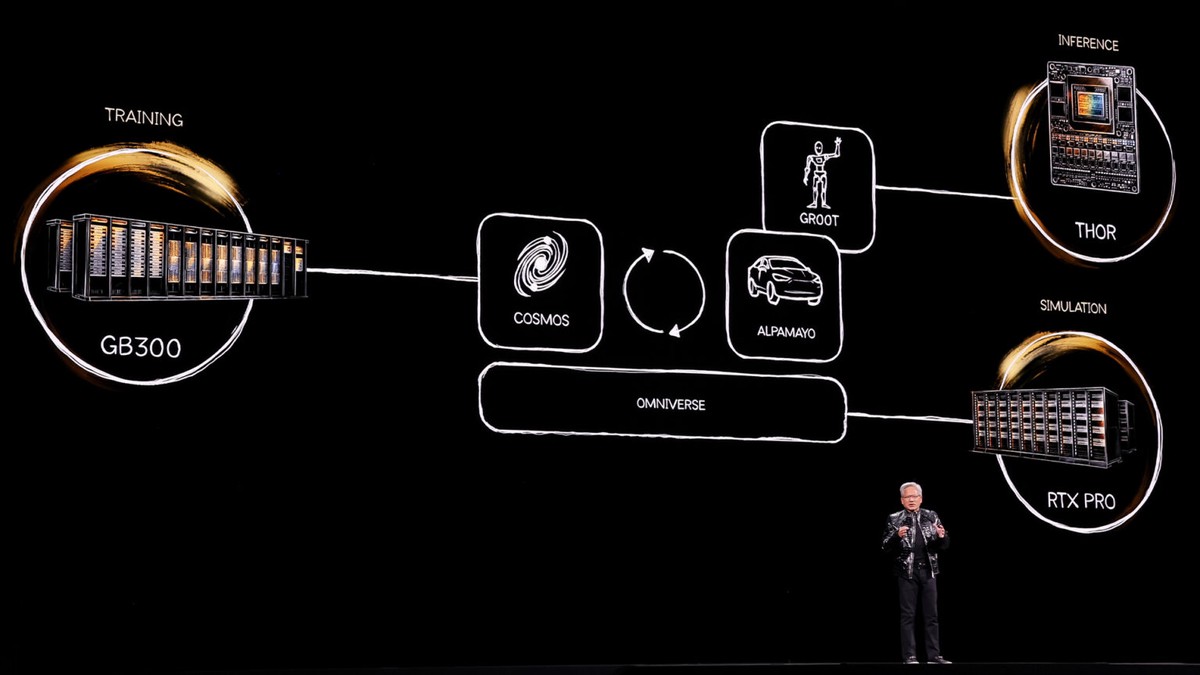

在汽車應用方面,黃仁勳宣布將開放去年底推出的自駕決策模型「Alpamayo」及其訓練數據,供車廠與開發者自由測試與部署。黃仁勳表示:「唯有連訓練資料一併開放,業界才能真正建立對AI模型的信任基礎。」

輝達也同場發表全新一代網路交換器與共同封裝光學(co-packaged optics)技術,針對萬台機器連結需求設計,正式挑戰Broadcom與Cisco在資料中心網路領域的市場地位。該技術可顯著降低延遲、提升頻寬,為Rubin平台建構提供核心骨幹。

針對日前收購AI晶片新創Groq核心技術與團隊,黃仁勳回應表示:「這不影響核心業務,但將助力擴展產品線。」此外,被美國總統川普允許出口至中國的前一代H200晶片需求強勁,輝達已申請出口許可,尚待美國政府審核中,財務長柯蕾絲(Colette Kress)強調:「我們將遵守所有貿易規範,但中國市場的需求仍無法忽視。」